このリポジトリーの Star 数は 3.5k Stars となっていたので Star 数としては個人的にはかなりのものでしたし、自分の欲しい機能を持っていたことや、使ってますよという声もいただいていたのでもったいない/申し訳ないという気持ちでいっぱいなのですが、それはそれとして不健全な状態が続いていたのでいったん区切りをつけることにしました。

やりたいことはいろいろあったのでいつか気まぐれで Unarchive するかもしれませんが。

代替

Cysharp から Source Generator ベースの ConsoleAppFramework という CLI ライブラリーがリリースされていますので今後新たにアプリを作ったりする場合にはこちらをお勧めします。

アーカイブに至った背景

アーカイブすることにした背景は単純で、モチベーションを維持して更新できなくなったということです。その結果 Issue や Pull request を長いこと放置した状態となっていて、不誠実極まりない状態になっていました。

一度たまり始めた Issue や Pull request が熟成すると、さらに開きたくなくなるという負のループが回るもので蓋を閉じたままどんどん熟成していきました。ですが心の奥にはなんとかしないと…という気持ちもあり、無限に小骨が刺さっているような感じでこれもまた気持ちに悪影響がある状態が長期間続いていました。

というわけで何もアクションをしないないままというのも全方位よくないので思い切ってアーカイブするに至りました。

モチベーションを失った背景

そもそもモチベーションを失ったのは何故かという話もあるのですが、これも結構単純な話で自分のために作ったようなものだけれど使う機会がなかったというところにあります。

先に書いた通り Cysharp では CLI フレームワークの ConsoleAppFramework というものを提供しているのですが Cysharp は自分の雇用主という関係があります。

そうなると Cysharp での仕事をしている中で Cocona を使うということは難しい、まあ難しいといっても使うなと言われているわけではないので個人的に勝手に気を使っている形なのですが、Cysharp のライブラリーを広める必要があるという点でねじれが起きるのは実際望ましくないと思っています。似たようなものが乱立するような大企業ならまだしも。(例えば「Cysharp では ConsoleAppFramework というライブラリを提供していますが、個人的に Cocona というのを作っていてこっちも便利でオススメですよ!」とはやはり言いにくい)

そんなわけで自分が使いたくなるシチュエーションでは使うことができず、かといって趣味で作るツールに CLI ツールはない (というかそんな真面目にコマンドラインを処理する必要がない) ので出番がなかったというわけです。

またこれは完全な趣味プロジェクトだったので業務時間中に開発される ConsoleAppFramework に対して、趣味の時間を割いて使わないライブラリーをメンテするという現実をダイレクトに見ることになったのもなかなか気を揉むところでした。(特に ConsoleAppFramework は大規模に書き換わり v5 で AOT セーフやパフォーマンスとかガラッと変わったので、それに追いつくには空き時間を大量に割く必要がある)

ConsoleAppFramework のほうが先発だったので、結局これはとても近いところで開発されている同じ領域をカバーするライブラリーにぶつかっていったのがそもそも悪いとしか言いようがないですね。なるべくしてなった結末かもしれません。

最後に

このライブラリーを見つけて、採用していただいた方々に大変感謝しています。ありがとうございました。

オープンソースのライブラリーを個人でメンテし続けている人はえらい…。

]]>ドゥリンの餅、10連で出た。ヤッタネー。

メモリーが値上がりしているからか、中華ミニ PC の類ですら値上がりしていてきびしみ…全て AI が悪い…。

]]>今回は今から眠くなる薬流しますねとか予告なく始まったようで、腕にぷすっとしてから少ししたらもう終わってました。そんな。

状態的には以前とそんなに変わらず炎症は起きているけれども、ぱっと見で重篤な問題があるようではなさそうということで。一応生検とったのでその結果は2週間後。

そんなに変わってなくて大変痛いのは納得感がないですが。

鎮静剤を使うとその後数時間は眠いので、結局終わってから帰ってまた夜まで寝落ち。

Duolingo の原神コラボクエスト完。ちょうど Duolingo 続けてるところでよかったです。

すいちゃんのどっから・ミニポスター付き(家庭用明太子440g)

受付開始日に注文したのですぐに届いていたのだけど、おなかの調子が悪くて辛いものは食べられないので冷凍庫行き…。かなしみ。

届いたのが6日で賞味期限が11日というのもなかなかシビアではあります。

ちょこっと舐めてみたけどこれは辛い。

]]>空月の歌 第六幕 完。

コロサン成分ヨシ!

まあ何となくそういう終わり方になる予感はしてましたよ。

]]>朝までお腹の不快感が続いて、睡眠の質が最底辺…。朝になって痛くなってきたので薬を飲んだところ一応和らいだのでアウト寄りのセーフ(仕事はなんとかできる)。

ヒガシマルのうどんスープとゼリー飲料で生きていきます。

ドゥリンは確保しました。ヤフォダが全然出てこない…。

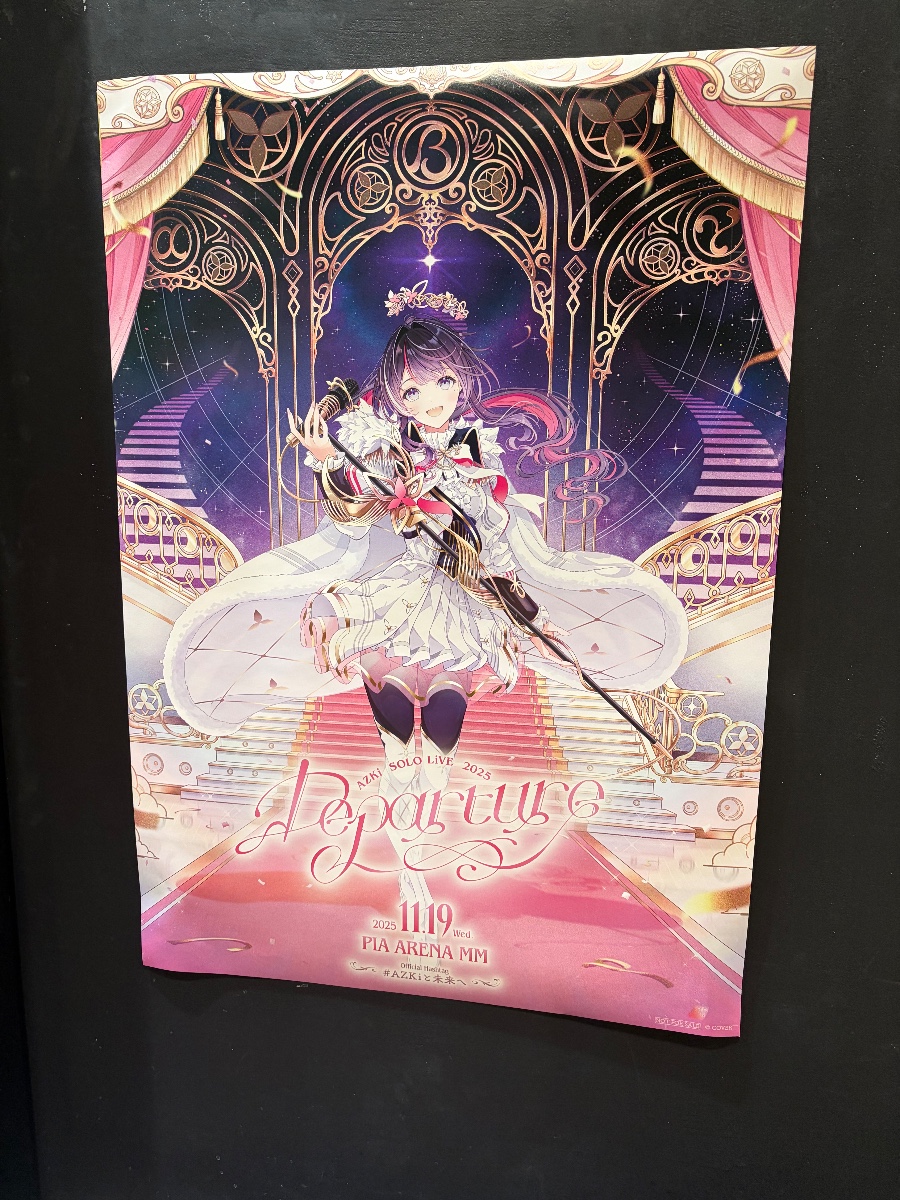

]]>前日夜から逆流性食道炎の症状が出て、昼ぐらいまで調子が悪かったけどなんとか行けるぐらいに回復したのでセーフ。

センターの真ん中の真ん中のあたりだったので割と悪くない席だったのでは。センターステージがあるのでそこまできた時はだいぶ近い感じがあって良かったですね。

しかし銀テープがV字に飛ばされるとどセンターには降ってこないという学びがありました。

ライブは Catch the Rainbow から行き始めたので6年ぐらい前ということで10周年の6割なので地味に時が経っていた…それは24歳が30歳にもなるわけで…。

しかし最近のライブはどこもチケットが高くなってきてて、昔いくらだったかなと思って遡ったら7,000円とか8,000円とかでだいぶ高くなりましたね。きびしい。

幻想シアター忘れててあぶなかった…。

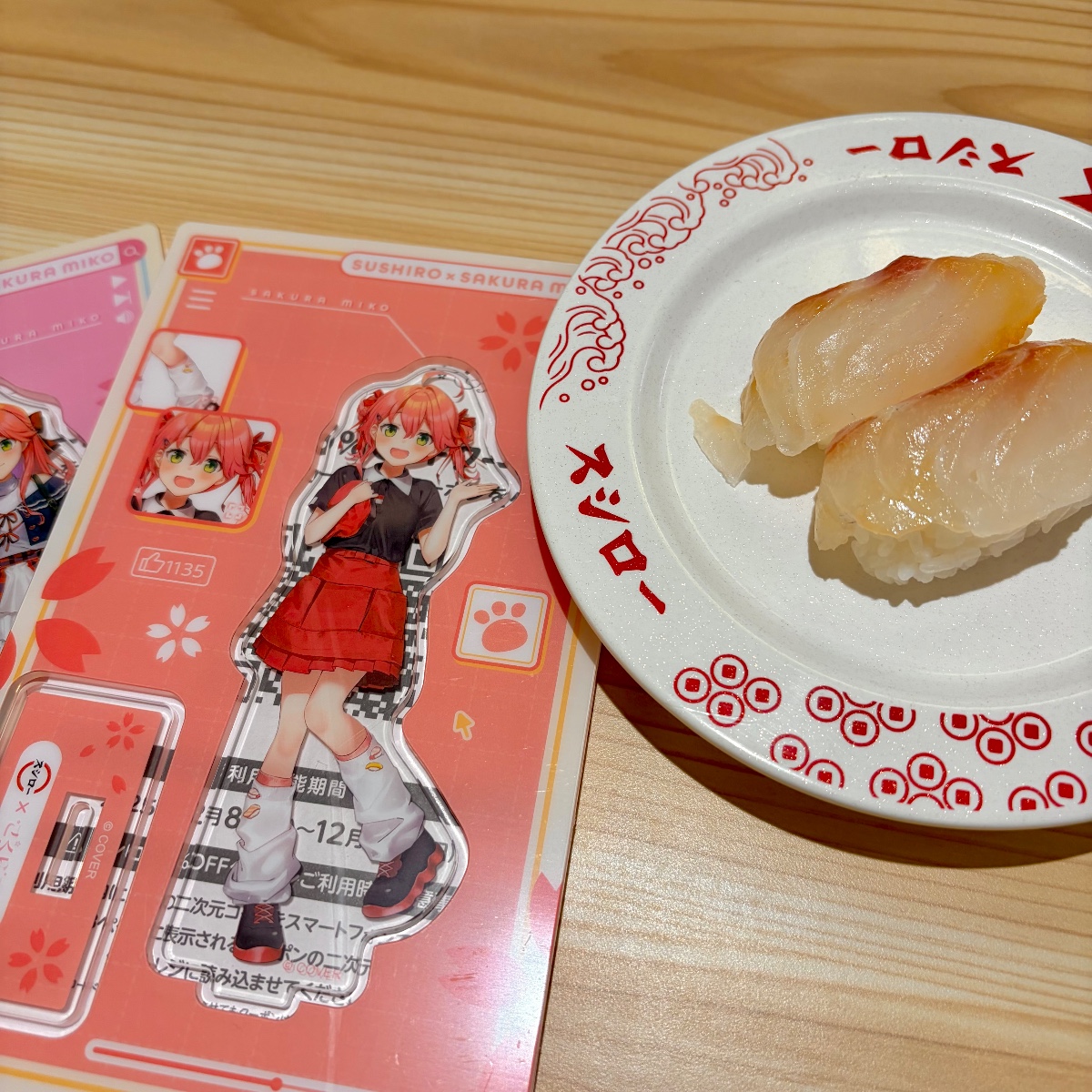

]]>夜はスシローのみこちコラボの2弾というかアクスタのために食べにいきました。

]]>スシロー × さくらみこ コラボキャンペーン『にゃっはろ~スシろ~!』 11/19(水)~ | おすすめ一覧 | 株式会社あきんどスシロー

お箸のセットは持ち帰りオンリーかつ今朝予約スタートなのに気づいてなくて争奪戦に敗北して悲しみ。

来週からアクスタなのでまた来週もスシローの予定です。

夕方からは AZKi のソロライブなのでぴあアリーナMMということで桜木町へ。

桜木町駅には Suica のペンギンのグッズを売っている Pensta という店があってのぞいてみんとす。

坂崎さんのサインもありました(割と新しい)。

AZKi SOLO LiVE 2025 “Departure”|ホロライブプロダクション

ぴあアリーナMMは Rhodanthe* のときぶりかもそんなことなかった一昨年来てた。今回は2階スタンド最後列。

あずきち、ぴあアリーナMMみたいな大きいところで満員で出来て本当によかったですね。

出自というか VSinger 的な流れを持っていたのに、歌を歌うことがメインではないホロライブの他のメンバーの方が大きい箱でやってるのを見て、はやく AZKi も大きいところでやってあげてと思ってたので本当によかった…。

ところでライブを見ていると今年の CEDEC で聞いたライブの裏側の技術的な話をやはり思い出していて、ホロライブのライブ公演はどうなってるの?実在感を大切にした照明演出システムや現場から見た視点を語る【CEDEC2025】 | インサイドの6ページ目にある話のリアルカメラと CG を合成する際の力技(黒フレームを差し込む)が何度見てもそんな上手くいっているのがすごい。

]]>オンラインストアで瞬殺だったのでリアルでももうないかと思ったけどまだまあまあ在庫ありそうでした。

その後ついでに NINTENDO TOKYO でゲッソーの洗濯ネットを買いました。

]]>ここ最近ずっと腰が痛いので病院に。

レントゲンを見せられた時なんか曲がってるけど撮影時の姿勢とかかな、と思ったら椎間板が潰れて実際曲がってた…。これはヘルニアとのこと。痺れとかは出てないので手術にはいたらずセーフ。

今まで何度か腰痛でレントゲンを撮ってきたけど、明確に出たのが初めてでちゃんと身体が壊れててインパクトあります。

マイナンバーカードの電子証明書の更新にも。特に待っている人はいなかったので約5分程度と一瞬でした。

]]>見て!知って!養生できる! お疲れのビジネスパーソン向け体験型ポップアップストア 「養命酒 養生テラスSHIBUYA」11月4日オープン

心拍と脈拍から交感神経、副交感神経などの調子を調べてくれる装置があって試したところ70歳相当の疲労具合とかでてて終わってた…。

疲労ストレス計 MF100 | 村田製作所 医療・ヘルスケア機器 一般・患者の方向け

というところで試飲もさせてもらいました。多分飲んだのは子供の頃に味見させてもらって以来な気がする…。まあ飲めなくはないけどおいしい!みたいな代物ではないですな。

そして折角なのでここでしか買えない養命酒300ml、かりんとう、にゅうめんを買って2000円以上のお買い上げとなり無事ガチャも回しました。ガチャのアクリルキーホルダーは製品化しそうなのかなと言う雰囲気。

ちなみに3回来店でステッカーもらえるそうですが、はたしてこの渋谷の田舎に繰り返し来てくれる人がどのくらいいるんだろうかという疑問はあります。

かりんとうはシナモンがきいていてちょっと珍しい風味でした。子どもにはウケなさそう。

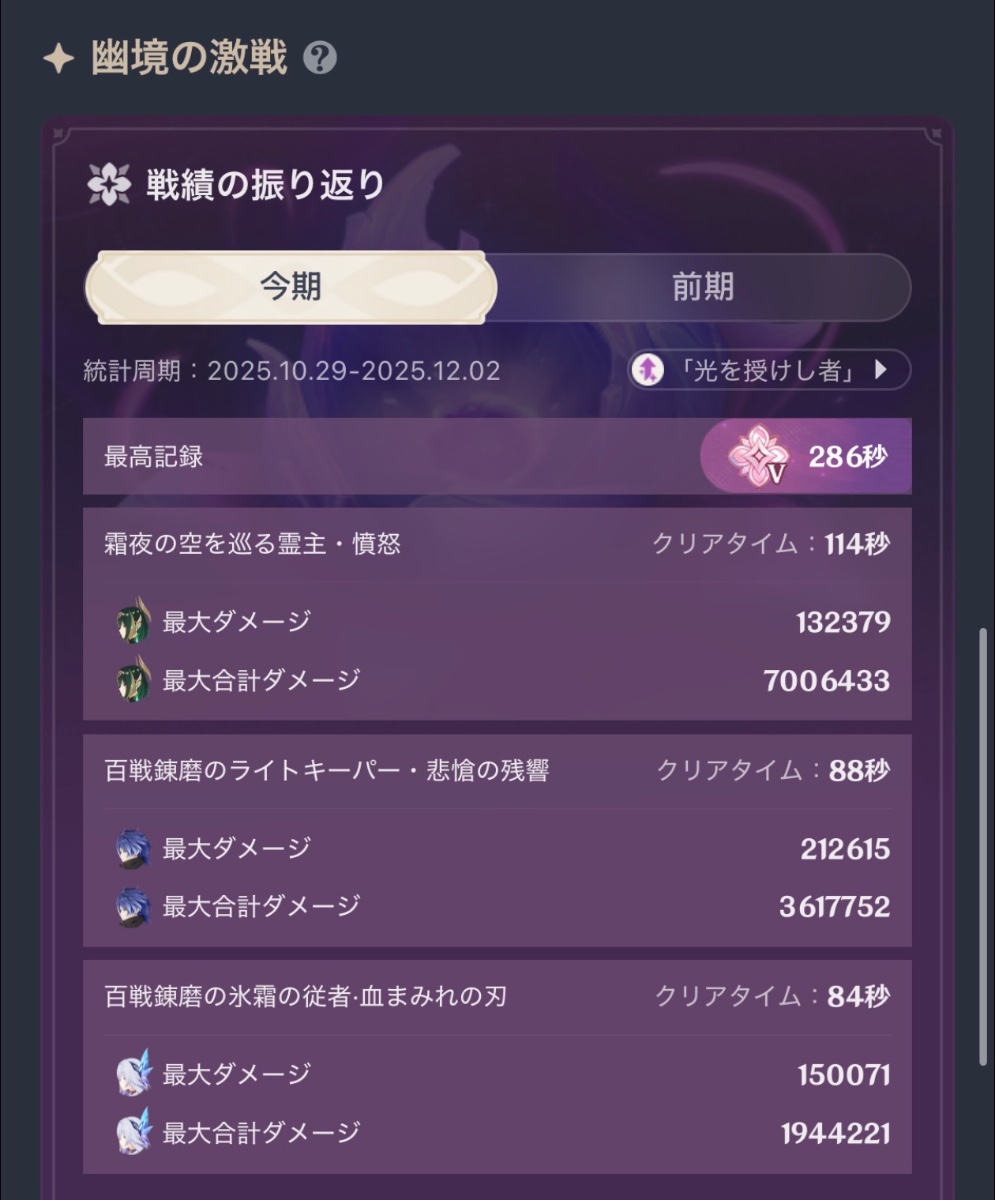

]]>幽境、エクストラも一応クリアできました。

]]>ということでカードを一度置いてしまったけど折角なので iPhone でやってみましたが、カードを出さなくて良いのはかなり楽なので良いですね。早く他のところも普及してほしいところ。

ネフェル餅の確保と第四幕を終えたので Luna II 大体完。

]]>第四幕を進める。なるほどネフェルの伝説任務が合体したような形になってる…というか区切りまで長い。

幽境はマスターは何とかできるけどエクストラはやはりダメかも。

鍛錬の道が終わって、今回はニィロウを1凸で。

]]>今まで家のキーボードは Microsoft Modern Keyboard with Fingerprint ID というやつを使っていたのだけど、Arm 版 Windows では動かないというのと USB micro B というのがそろそろ厳しいので買い替えたいという気持ちがありまして。

要件としてコンパクトでぺちぺちなキーボード、Bluetooth で複数ペアリングでき、USB-C で繋がること、見た目が良いことといったあたりでなんかないかなと思っていたところ、ちょっと前に Razer から Joro というのが発売されて、店頭で触った感じも好感触でした。

ただまあ2.2万円なので今すぐ買うか?というと…って感じで見送っていたところ Amazon で4500円クーポンが出てきたのでバイナウ待ったなし。

感想としてはハードウェアは特に文句はないけど、Razer Synapse がなんか微妙というか挙動があやしいのが気になる感じでしょうか。

マウスを買った時にも思ったけど Razer のハードウェアコンパニオンアプリ、バックグラウンドサービスがわさわさ動いてたりするのが気になるんですよね…。

説明書などには書いてないですが、ファンクションキーは Fn キーと同時押しとなっているところ、設定から逆(Fn キー押すとマルチメディアキーになる)にできます。Fn ロックはないのでさすがにこれがなかったら死んでました。

まあひとまずは問題なく使えることは確認できたのでよしとします。

]]>サンドローネのプレイアブルなにとぞ…。

]]>普段見れない車両基地や整備しているところなどを見れて良きでした。整備場みたいなのは特に見る機会ないですしね。

車両洗浄体験も参加できて、車の洗車機みたいなのを想像してたら、まあ似たようなものだけど意外と一瞬で乾燥もないしなるほどーって感じ。

あいにくの天気だったけど、ギリギリ雨が強くならなくて済んだのも良かったですね。帰る頃にちょうどラブライブ!ニジガクの一日駅長イベントをやっていました。

夜ごはんは新福菜館。

Anker Nano Power Bank を購入。

Anker 621 Magnetic Battery (MagGo) を今まで使っていたけど、さらに薄くなって 15W 対応ということでよさそう。iPhone Air だとこれぐらいなら貼り付けたままポケットなどに入れても全然余裕なのは良いですね。

]]>腰が終わってるのでマッサージしてもらったり。やはり脚がだいぶ硬くなっていた模様。

これで少しはマシになって欲しいけど、まあ運動しろって話ですね…。

こんにちはネフェル。

モチーフ武器はまあまだ焦る時間ではない。、

それはそうとなんかよくわからないけど Epic のランチャーを起動してウィンドウ表示してないとフレームレートが下がる…。

]]>国立がんセンターとがん研究会が別物だったと初めて知ったマン。

]]>まだ少ししかやってないけど、なるほどこれは普通に難しいかも。移動のコントロールもアクセルと方向転換みたいな感じなのでまっすぐ歩くという概念がほぼない。

それはそれとして、Switch 版を Switch 2 でやってるとグラフィックの粗さが気になりますね。Steam 版と比べて演出周りが控えめみたいな話があったけど、それよりグラフィックのほうが気になりました。

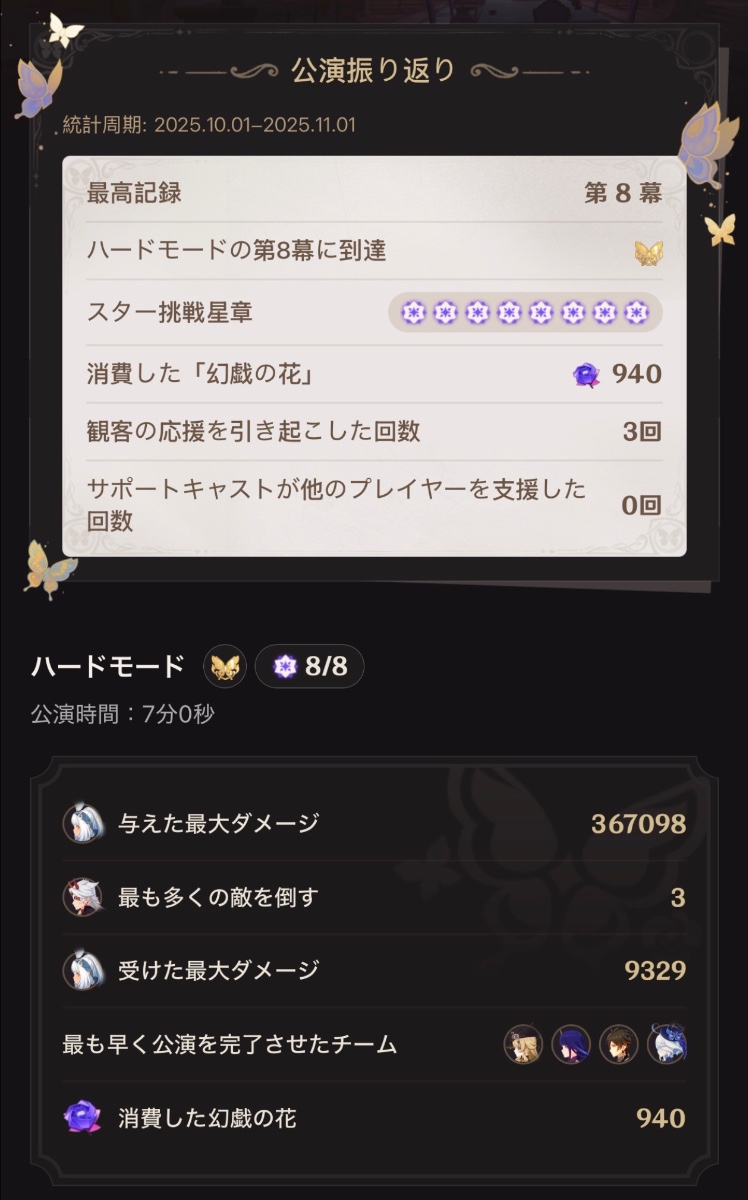

幻想シアターのハードをこなす。ハードのクリアはそこまで難しくはないけど、マスターはキャラが育ってないのでそもそも厳しい。(控えが足りない)

スタバで飲み物と食べ物を買おうと思い、Stars が溜まっているので eTicket 2個に交換して割引で大勝利!と思ったものの一回の会計につき一つしか使えない罠を忘れてて死。アップルパイは美味しかったです。

]]>